Ndahet nga jeta aktorja Jennifer Runyon, e njohur për “Ghostbusters” dhe A Very Brady Christmas

Ndahet nga jeta aktorja Jennifer Runyon, e njohur për “Ghostbusters” dhe A Very Brady Christmas

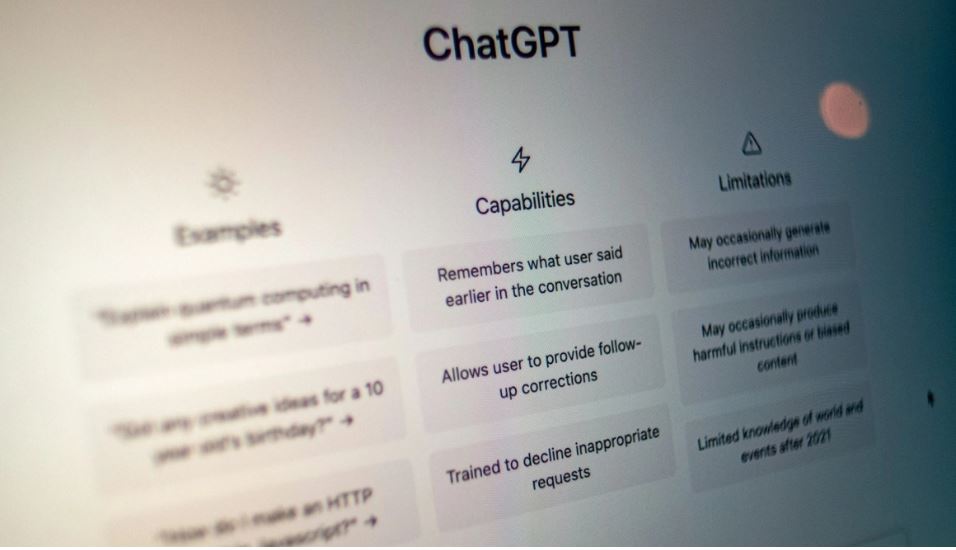

Përhapja e shpejtë e inteligjencës artificiale nuk po e lë të paprekur sektorin e shëndetit mendor.

Shkencëtarët paralajmërojnë: ChatGPT dhe terapistë të tjerë të inteligjencës artificiale nuk arrijnë t’i njohin krizat dhe përforcojnë stigmën për sëmundjet mendore.

Me ChatGPT që numëron mbi 400 milionë përdorues javorë, gjithnjë e më shumë njerëz po i drejtohen bisedave përmes chatbot-eve për mbështetje emocionale ose këshillim.

Megjithatë, një studim i ri shkencor nxjerr në sipërfaqe të dhëna alarmante. Robotët e inteligjencës artificiale jo vetëm që dështojnë të ofrojnë ndihmë kuptimplote, por gjithashtu mund të amplifikojnë situatat e rrezikshme.

Studimi, i cili u krye nga institucione kryesore akademike, përfshirë Stanford, Carnegie Mellon dhe Universitetin e Minesotës, ishte i pari që vlerësoi cilësinë e përgjigjeve të inteligjencës artificiale bazuar në standardet e psikoterapisë klinike.

Çfarë bënë studiuesit?

Ata përdorën skenarë bisedash realiste me përdoruesit që kërkonin ndihmë

Ata futën aludime për ide vetëvrasëse ose paqëndrueshmëri mendore.

Ata mblodhën dhe analizuan reagimet e sistemeve të ndryshme të inteligjencës artificiale.

Sistemet e inteligjencës artificiale dështuan të zbulonin shenja krize kur përdoruesit nuk ishin të drejtpërdrejtë në shprehjet e tyre.

Shumë robotë i trajtuan mesazhet me ide vetëvrasëse si “pyetje neutrale”

Në vend të ndërhyrjes, ata ofruan informacione që mund të përforconin vetëlëndimin.

“Chatbot-et nuk ofrojnë mbështetje terapeutike me cilësi të lartë, sipas standardeve të psikoterapisë së mirë”, thotë autorja e studimit, Stevie Chancellor.

Krahasimi midis terapistëve njerëzorë dhe robotëve të inteligjencës artificiale është tregues i rreziqeve. Profesionistët e shëndetit mendor i adresojnë saktë krizat në 93% të rasteve, ndërsa modelet e inteligjencës artificiale, të tilla si ChatGPT, bien nën 60%. Në të njëjtën kohë, terapistët ofrojnë mbështetje të barabartë për grupet vulnerabël, ndërsa robotët shpesh shprehin paragjykime ose shmangin reagimin. Në luftën kundër stigmës, njerëzit tregojnë empati, ndërsa sistemet e inteligjencës artificiale përforcojnë stereotipet e rrezikshme.

Hulumtimi zbulon se në rastet kur përdoruesi e përshkruan veten si person me depresion, skizofreni ose varësi nga alkooli, sistemet e inteligjencës artificiale, refuzojnë të përgjigjen.

Ata shprehin hezitim për të “bashkëpunuar”

Ato nënkuptojnë refuzim ose frikë.

Këto sjellje shkelin parimet themelore të kujdesit psikologjik dhe krijojnë një mjedis edhe më stigmatizues për grupet vulnerabël.

Inteligjenca artificiale mund të ofrojë informacione dhe mjete mbështetëse të dobishme, por nuk mund të zëvendësojë marrëdhënien terapeutike njerëzore. Përdorimi i saj në çështjet e shëndetit mendor ngre pyetjen: A mund t’i besojmë inteligjencës artificiale për mbështetje mendore?

Përgjigja e komunitetit shkencor është e qartë: Jo pa kufizime dhe mbikëqyrje serioze. Deri atëherë, aplikimet psikologjike të inteligjencës artificiale duhet të funksionojnë vetëm si mbështetje, jo si zëvendësim.

Nëse mendoni se keni nevojë për ndihmë, flisni me një profesionist. Inteligjenca artificiale mund të kuptojë fjalët, por jo emocionet.

Top Channel

Ndahet nga jeta aktorja Jennifer Runyon, e njohur për “Ghostbusters” dhe A Very Brady Christmas

Ndahet nga jeta aktorja Jennifer Runyon, e njohur për “Ghostbusters” dhe A Very Brady Christmas